外媒评测GPT-4:较上一代脱胎换骨,但依然有缺陷存在误导性

“GPT3或3.5像一个六年级学生,而GPT-4像一个聪明的十年级学生。” 对于最新发布的GPT-4模型,有美国初创企业人士这样评价。

当地时间3月14日,OpenAI推出了“深度学习的最新里程碑”GPT-4。据介绍,这是一款大型多模态模型,与ChatGPT所用的模型GPT-3.5相比,它的文本处理量扩大至2.5万个单词,还增加了图片处理功能。

在一直被外界诟病的准确性方面,GPT-4也有所改进。据OpenAI的介绍,在公司内部的对抗性真实性评估中,GPT-4的得分比GPT-3.5高40%,相应的“不允许内容请求的倾向”降低了 82%,根据政策响应敏感请求(如医疗建议和自我伤害)的频率提高了29%。

OpenAI将GPT-4称为“里程碑”式的模型,它是否如宣传的那般智能?与此前的GPT系列模型相比,它到底在哪些方面有所改进?

准确性更高、专业性更强

根据《纽约时报》3月14日发布的GPT-4测评报道,与ChatGPT相比,这款模型的准确性更高、专业性更强。

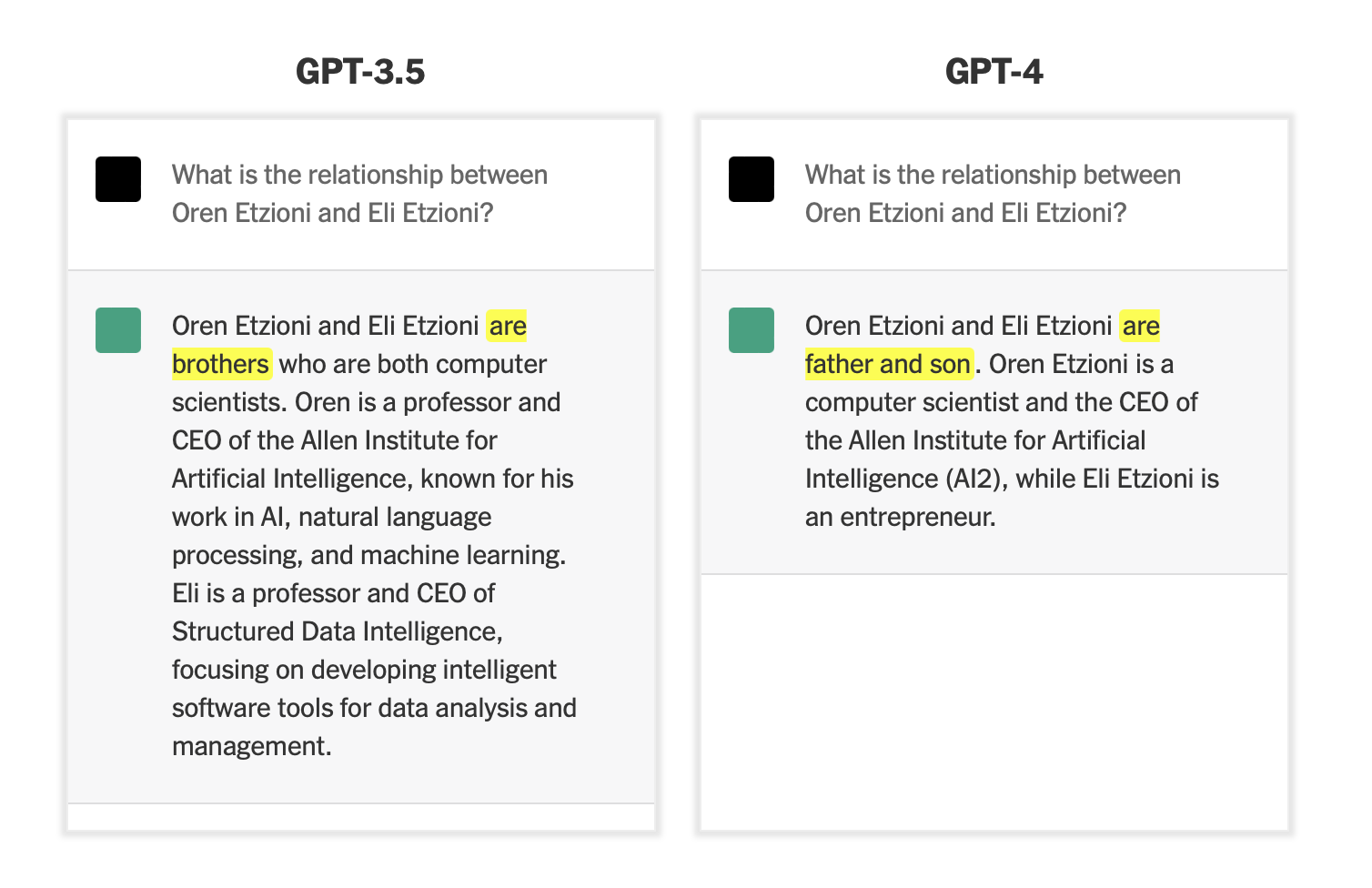

一位AI研究员分别询问ChatGPT和GPT-4“艾伦人工智能研究所前CEO Oren Etzioni以及企业家Eli Etzioni是什么关系”,GPT-4准确回答出他们是父子关系,而ChatGPT错误地将他们说成兄弟。

不过,在解释了上述两名人士的身份时,GPT-4和ChatGPT都犯了一些错误——这两个机器人均将Oren解释为艾伦人工智能研究所的CEO,但事实上,Oren已经于2022年宣布卸任CEO一职。

但考虑到ChatGPT的数据库仅更新至2021年,而GPT-4的训练数据也只追踪到2021年9月,这一错误显得情有可原。

专业性方面,北卡罗来纳大学教堂山分校(University of North Carolina at Chapel Hill)的医学副教授兼心脏病学家Anil Gehi通过询问医学领域的专业问题,发现GPT-4具有一定的专业知识。

Gehi向GPT-4描述了一名患者的病史以及其入院后经历的并发症,并在对话中使用了较为专业的医学术语。当他询问GPT-4应该如何治疗病人时,它给了完美的答案,Gehi评价称“这正是我们对待病人的方式”。他还补充道,在尝试其他场景时,GPT-4给出了同样令人印象深刻的答案。

这似乎也对应了OpenAI所说的,与GPT-3.5相比,GPT-4在响应医疗建议和自我伤害等敏感请求方面,频率提高了29%。

不过,Gehi认为GPT-4并不会每次都能回答专业知识,因此仍然需要专业人士对其内容进行判断并执行相应的医疗程序。

能够处理复杂图片、更具幽默感

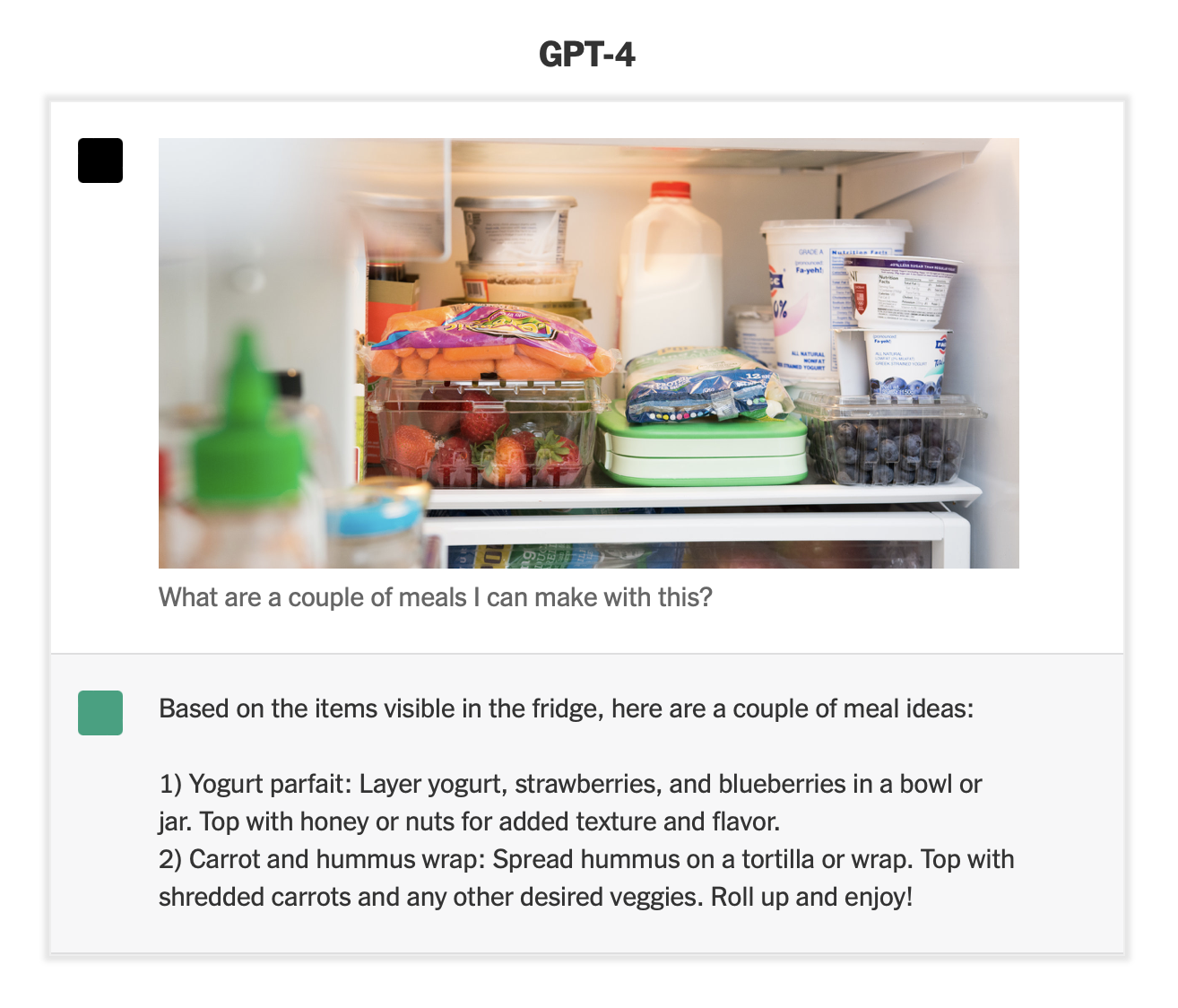

与此前发布的GPT系列模型相比,GPT-4最大的突破之一是能够处理图像内容。《纽约时报》的测试显示,它能够识别较为复杂的图片信息,并对其进行解读。

向GPT-4发送塞满食物的冰箱的图片,并询问图中食材能够做几顿饭,它给出了两种菜谱的具体制作方法——食物的搭配相当丰富,还考虑到了口感和风味。

它的回答为,“根据冰箱里可见的物品,有以下食谱:1)酸奶冻糕:将酸奶、草莓和蓝莓分层放在碗或罐子里,顶部撒上蜂蜜或坚果以增加口感和风味。2)胡萝卜和鹰嘴豆泥卷:将鹰嘴豆泥涂在玉米饼或卷上,上面放上切碎的胡萝卜和任何其他想要的蔬菜。”

值得注意的是,OpenAI目前尚未对外开放图片识别分析,因为担心这项功能会被滥用。

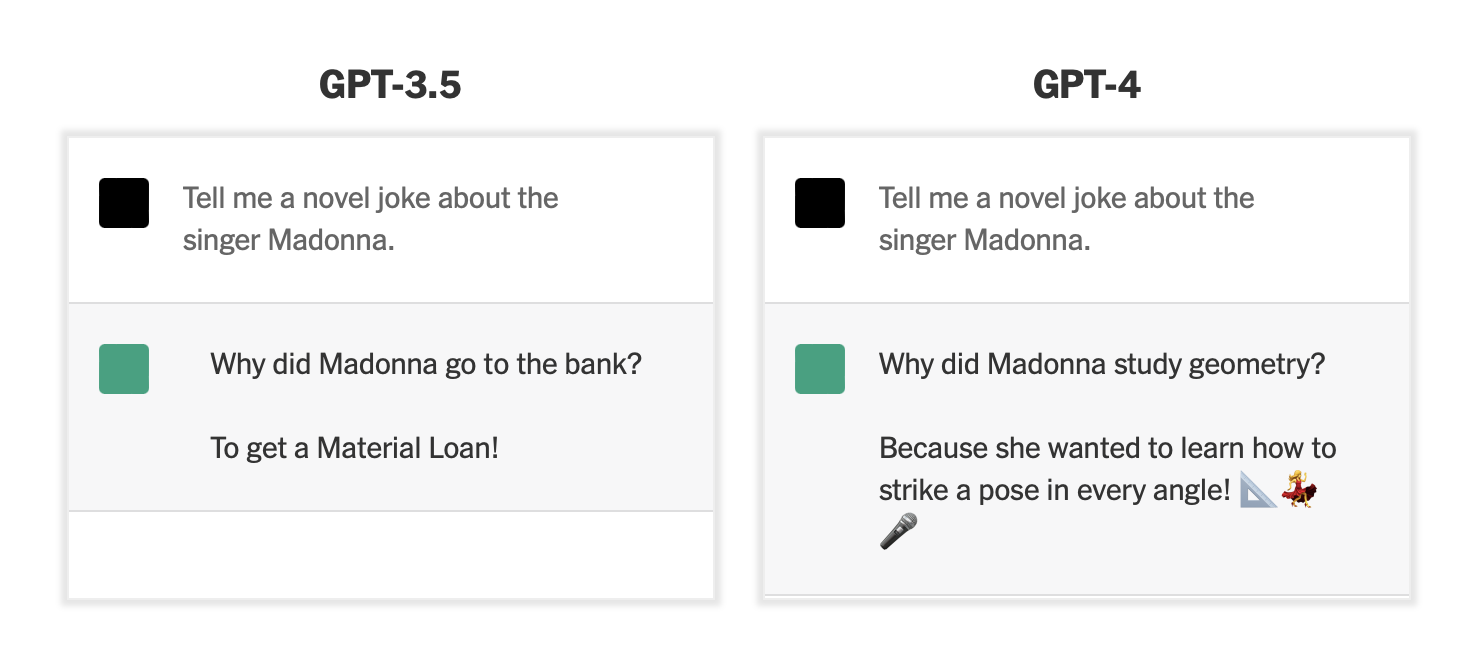

此外,《纽约时报》还发现,GPT-4的幽默感有所提高。

当被要求提供“关于歌手麦当娜的新鲜笑话”时,GPT-4回答“麦当娜为什么要学习几何?因为她想学会如何摆出各个角度的姿势!”在回答的最后,它还“俏皮”地附上了三角尺、跳舞和麦克风的表情符号。相比而言,GPT3.5的回答就显得平平无奇,并不那么好笑了。

业内人士称警惕AI存在的潜在风险

自OpenAI去年发布其图像生成技术Dall-E 2以来,科技公司一直在炒作生成式AI(人工智能)的可能性;去年11月发布的ChatGPT更像一颗火种,迅速点燃各界对AI的热情。

不过,自发布以来,ChatGPT及其竞争对手的准确性一直为外界诟病,微软和谷歌在展示其聊天机器人相关新技术时,均出现过大大小小的失误。因此,OpenAI花费了6个月的时间,利用对抗性测试程序和ChatGPT的经验教训,迭代调整GPT-4。

OpenAI总裁兼联合创始人Greg Brockman说道,“GPT-4比GPT 3.5犯的错误更少,不过要达到最佳效果仍需辅以人工检查。……它并不完美,但你也不完美,它是让你达到新高度的工具。”Brockman还表示,OpenAI计划把这些通用知识技能推广到各个不同的领域。

虽然OpenAI一直在声称努力改进GPT系列并取得了进展,但该公司也坦然承认,GPT-4还存在一定缺陷。

“它有时会犯简单的推理错误……或者过于轻信用户的错误陈述。有时它会像人类一样在难题上失败,例如在它生成的代码中可能会引入安全漏洞。”OpenAI表示。

目前对于生成式AI,不少业内人士仍然充满担忧。科技媒体CNET表示,大型语言模型的回复有时令人印象深刻,似乎它们真的可以理解大量的问题,并且能够用听起来有点生硬的语言进行交流。不过,从根本上说,大型语言模型以及AI并不能真的了解某样东西,它们只是以精确的统计方式将单词串在一起。

对此,不少研究人员发出警告,希望用户警惕大型语言模型带来的“随机鹦鹉(stochastic parrots)”风险。“随机鹦鹉”指用随机概率信息将语言形式的序列随意拼接在一起的实体,但不涉及任何含义,是对机器学习和人工智能模型在实际应用中可能出现的误导性表现的一种戏谑称呼。

《华尔街日报》援引人工智能分析师的话称,生成式AI仍然存在潜在问题,虽然ChatGPT和其他文本生成器在面对高质量提问时,能给出准确回复,但在其他主题方面可能会给出带有种族主义和性别歧视的答案。

专门研究国际商务和信息安全的加州大学伯克利分校教授Steven Weber 表示,现在判断这项技术还为时过早,因为它尚未在现实世界中得到广泛测试。

目前OpenAI没有公开GPT-4的参数数量及运行成本,不过《纽约时报》指出,由于OpenAI新的聊天机器人接受了更多数据训练,其成本将会增加。OpenAI首席技术官Mira Murati称,如果服务器过载,公司可能会限制用户使用。

特别声明:本文为转载/投稿,仅代表该原作者观点。NESTIA仅提供信息发布平台。

Comments

Leave a comment in Nestia App